| Autor |

Nachricht |

Aruna_Gast

Gast

|

Aruna_Gast Verfasst am: 01. Aug 2023 22:55 Titel: GPT-3: 175 Milliarden Neuronen oder Synapsen? Aruna_Gast Verfasst am: 01. Aug 2023 22:55 Titel: GPT-3: 175 Milliarden Neuronen oder Synapsen? |

|

|

Meine Frage:

Ist jetzt eher Informatik, aber hier laufen ja auch Informatiker rum bzw. Physiker, die sich auskennen:

Ich hab gelesen, dass GPT-3, das Sprachmodell, das ChatGPT zugrunde liegt, auf einem neuronalen Netzwerk mit 175 Milliarden Neuronen basiert.

Das wären rund doppelt so viel, wie in einem menschlichen Gehirn.

An anderen Stellen wird diese Zahl eher mit der Zahl von Synapsen verglichen, also die Verbindungen zwischen den Neuronen.

Das wären im menschlichen Gehirn so 100 Billionen.

Im Wikipediaartikel zu "Generative_Pre-trained_Transformer_3" ist von "175 Milliarden Neuronen Parametern" die Rede.

Weiß jemand Genaueres, bzw. kann die Begriffe in Beziehung zueinander setzen?

Meine Ideen:

Ich war überrascht über die große Zahl und ich hätte gedacht, dass heutige KI noch weit von der Komplexität eines menschlichen Gehirns entfernt ist, daher würde ich eher auf Synapsen tippen. Vielleicht ist die Funktionsweise von menschlichen Gehirnen und künstlichen neuronalen Netzwerken allerdings so unterschiedlich, dass man deren Leistungsfähigkeit nicht so einfach an so einfachen Kennzahlen vergleichen kann.

|

|

|

ML

Anmeldungsdatum: 17.04.2013

Beiträge: 3405

|

ML Verfasst am: 02. Aug 2023 14:17 Titel: Re: GPT-3: 175 Milliarden Neuronen oder Synapsen? ML Verfasst am: 02. Aug 2023 14:17 Titel: Re: GPT-3: 175 Milliarden Neuronen oder Synapsen? |

|

|

Hallo,

| Aruna_Gast hat Folgendes geschrieben: |

Ich hab gelesen, dass GPT-3, das Sprachmodell, das ChatGPT zugrunde liegt, auf einem neuronalen Netzwerk mit 175 Milliarden Neuronen basiert.

Das wären rund doppelt so viel, wie in einem menschlichen Gehirn.

|

Neuronen sind in der Biologie Nervenzellen, die Informationen weiterleiten.

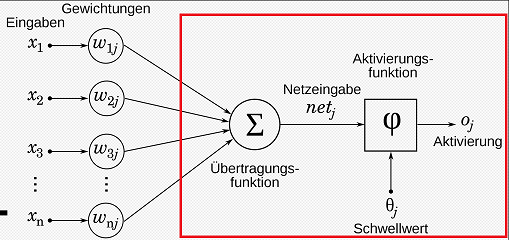

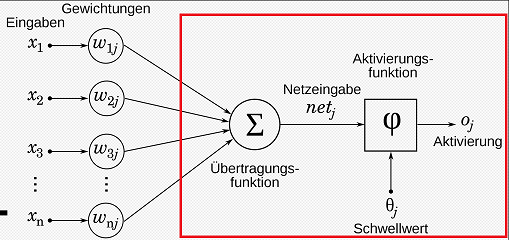

Neuronen in einem künstlichen neuronalen Netz sind letztlich mathemtische Funktionen mit mehreren Eingabewerten, die eine Rechnung durchführen und dann einen Wert weitergeben (ggf. unter Manipulation/Schwellwertberechnung u. ä.). Ich habe sie unten im Bild rot gekennzeichnet.

Synapsen wären in der Analogie dann die Andockstellen, hier repräsentiert durch Eingangswerte.

| Zitat: |

Weiß jemand Genaueres, bzw. kann die Begriffe in Beziehung zueinander setzen?

|

Die Zahlen sind beeindruckend. Man kann sie aber nicht 1:1 vergleichen. Die Leistungsfähigkeit eines neuronalen Netzes hängt neben der Größe entscheidend davon ab:

- ob seine Struktur und die Lernparameter dem Problem angepasst sind und

- wie es angelernt wird.

Struktur

Bei der Bilderkennung beispielsweise macht es bei ansonsten gleicher Größe einen himmelweiten Unterschied, ob man ein "fully connected layer" oder ein "convolutional layer" als wesentlichen Teil der Bilderkennung anlernt, da die internen Rechnungen, die im Convolutional Layer standardmäßig durchgeführt werden, den Erkennungsprozess stützen. Die Rechnungen, die das convolutional layer automatisch durchführt, müsste das fully connected layer gewissermaßen erst lernen, wobei dann große Teile seiner Synapsen und Neuronen ohne Funktion wären.

Die Strukturen bei ChatGPT sind vor allen Dingen auf Sprache optimiert; das ist das, was das Netz am besten kann.

Was ich aber nicht weiß ist, ob es schon künstliche neuronale Netze gibt, deren Struktur sich beim Anlernen verändert. Das wäre eigentlich logisch (und wahrscheinlich kenne ich es bloß nicht). Es hätte dann möglicherweise sogar zur Folge, dass es -- wie beim Menschen -- Lernfenster gibt, also Zeiten, in denen man gewisse Dinge noch lernen kann und Zeiten, in denen das nicht mehr geht.

Anlernen

Lebewesen werden letztlich durch alle Sinnesorgane an verschiedenen Orten und beispielsweise auch durch sehr strukturiertes Lernen (Schule, Universität) angelernt. Lebewesen haben darüber hinaus so etwas wie Schmerz, Überlebenswillen u. ä. eingebaut und prüfen idealerweise intern ihr Gelerntes auf logische Konsistenz, wobei man eine gewisse Inkonsistenz dann letztlich aushalten muss. In dieser Form und Fülle sehe ich das bei künstlicher Intelligenz noch nicht, wobei ich aber auch kein grundsätzliches Problem bei der Realisierung sehe.

Bei Chat-GPT hat man gewissermaßen einen Papagei programmiert, der Sätze vervollständigen kann, und hat zum Anlernen das halbe Internet reingeschüttet. Was herauskommt ist ein ausgesprochen leistungsfähiges Sprachmodell. Ich denke, dass ChatGPT ein Meilenstein bei der Entwicklung von KI ist und erst der Anfang von dem ist, was auf diesem Gebiet noch kommt.

Viele Grüße

Michael

Bildquelle: https://de.wikipedia.org/wiki/K%C3%BCnstliches_neuronales_Netz#/media/Datei:NeuronModel_deutsch.svg

(ergänzt um rotes Kästchen)

| Beschreibung: |

|

| Dateigröße: |

33.35 KB |

| Angeschaut: |

22434 mal |

|

Zuletzt bearbeitet von ML am 03. Aug 2023 16:07, insgesamt einmal bearbeitet |

|

|

DrStupid

Anmeldungsdatum: 07.10.2009

Beiträge: 5044

|

DrStupid Verfasst am: 03. Aug 2023 00:22 Titel: Re: GPT-3: 175 Milliarden Neuronen oder Synapsen? DrStupid Verfasst am: 03. Aug 2023 00:22 Titel: Re: GPT-3: 175 Milliarden Neuronen oder Synapsen? |

|

|

| Aruna_Gast hat Folgendes geschrieben: | | Vielleicht ist die Funktionsweise von menschlichen Gehirnen und künstlichen neuronalen Netzwerken allerdings so unterschiedlich, dass man deren Leistungsfähigkeit nicht so einfach an so einfachen Kennzahlen vergleichen kann. |

Darauf würde ich nicht wetten. Nach der Kartierung des Konnektoms der Drosophila-Larve hat man überrascht festgestellt, dass seine Architektur der von modernen Neuronalen Netzwerken verblüffend ähnelt. Offenbar sind Mensch und Natur hier unabhängig voneinander zu denselben Lösungen gekommen.

|

|

|

ML

Anmeldungsdatum: 17.04.2013

Beiträge: 3405

|

ML Verfasst am: 03. Aug 2023 01:26 Titel: Re: GPT-3: 175 Milliarden Neuronen oder Synapsen? ML Verfasst am: 03. Aug 2023 01:26 Titel: Re: GPT-3: 175 Milliarden Neuronen oder Synapsen? |

|

|

| DrStupid hat Folgendes geschrieben: | | Offenbar sind Mensch und Natur hier unabhängig voneinander zu denselben Lösungen gekommen. |

Ich dachte, die künstlichen neuronalen Netze seien nach dem Vorbild der Natur angelegt worden.

|

|

|

DrStupid

Anmeldungsdatum: 07.10.2009

Beiträge: 5044

|

DrStupid Verfasst am: 03. Aug 2023 10:35 Titel: Re: GPT-3: 175 Milliarden Neuronen oder Synapsen? DrStupid Verfasst am: 03. Aug 2023 10:35 Titel: Re: GPT-3: 175 Milliarden Neuronen oder Synapsen? |

|

|

| ML hat Folgendes geschrieben: | | Ich dachte, die künstlichen neuronalen Netze seien nach dem Vorbild der Natur angelegt worden. |

Ja, wurden sie. Aber sie haben sich viel schneller entwickelt als die Hirnforschung. Dabei sind Strukturen entstanden, die man in der Natur erst später entdeckt hat (z.B. Rückkopplungsschleifen).

|

|

|

|

|